浅谈数据中心冷却技术的“前世今生”

本文转载背景

本文转载自微信公众号:Deepknowledge

副标题:Sabey公司数据中心通过气流通道封闭优化数据中心风循环冷却

原文作者:John Sasser

原文出处:https://journal.uptimeinstitute.com/a-look-at-data-center-cooling-technologies/

数据中心冷却技术的唯一目的是维持适合信息技术设备(ITE)运行的环境条件。为实现这一目标需要把信息技术设备(ITE)运行过程产生的热量转移至冷却散热器。大多数数据中心的运营者都期望冷却系统能够连续可靠的运行。

我清楚地记得曾经和一个运行数据中心很多年的机械工程师(译者注:暖通空调技术在美国的专业划分上属于机械类)的对话,他觉得大多数机械工程师并没有真正理解数据中心的运行与设计,他解释说,大多数暖通空调工程师在介入数据中心设计前是从事办公室或者住宅的设计,专注于舒适性冷却。他认为他们在那些项目设计中掌握的范式并不能很好地适用于数据中心。

重要的是,即使数据中心必须让那些在里面工作的职员安全健康,也要清楚舒适性冷却不是数据中心冷却系统的主要目的。事实上,对于长期工作在数据中心里的人来说那种不舒适感完全可接受(也不足为奇)。

与任何精心设计的系统一样,数据中心冷却系统应该有效地服务于它的功能。数据中心非常耗能,很可能冷却系统消耗与它服务的计算机一样多(或更多)的能源。与之相反,一个设计和运行良好的冷却系统可能只消耗信息技术设备(ITE)所用能源的一小部分。

在这篇文章里,我将提供一些数据中心冷却的历史。然后讨论一些数据中心冷却的技术要素,伴随了一些数据中心冷却技术的比较,也包括我们Sabey数据中心使用着的一些冷却技术。

摩尔定律的经济性崩溃

从早期到2000年代中期,设计与运行人员一直担心风循环冷却技术应对越来越耗电的服务器的冷却能力。在设计功率密度接近或超过每机柜5千瓦(kW)的情况下,一些言论认为,运营商将不得不求助于背板换热器(译者注:Rear-Door Heat Exchangers通常简称为RDHx)和其他行间冷却(In-Row cooling)方式以跟上日益增长的功率密度。

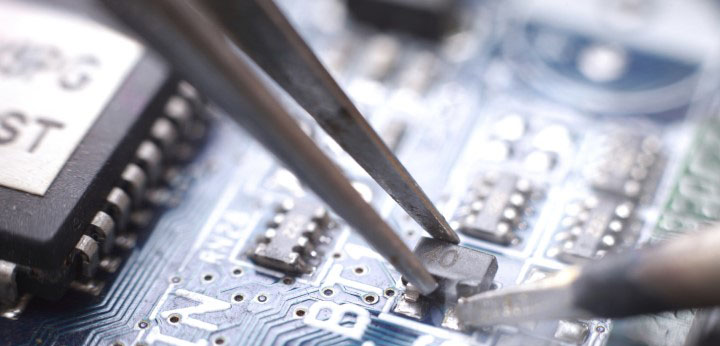

2007年,Uptime Institute的Ken Brill有一个著名的预测,即摩尔定律的经济性崩溃,他说,在没有技术进步的情况下,随着越来越多的晶体管集成到芯片上产生的热量增长将使得数据中心冷却到达不再具有经济可行性的终点(见图1)。

图1.ASHRAE新数据通信设备电力图表,2005年2月1日出版

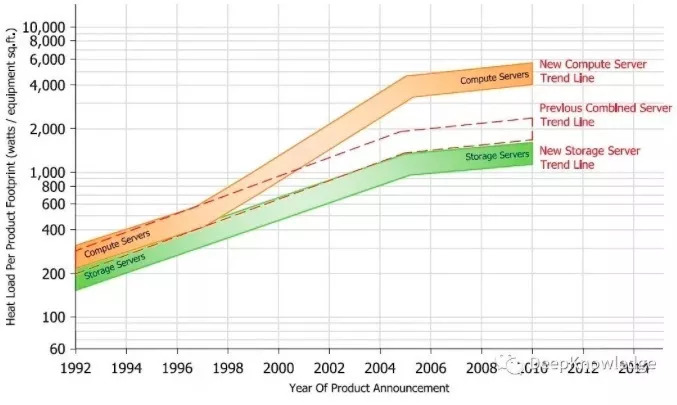

美国国会甚至也参与进来。这表明国家领导人们已经关注到数据中心和他们的能源能耗量。国会指示美国环境保护署(EPA)提交一份关于数据中心能源消耗的报告(公法编号109-341,译者注:实际为109-431)。这项法律另外还指示美国环境保护署(EPA)确定能效提升策略并推动相关市场。据该报告预计,除非采取能显著提高能效的措施,否则数据中心将会大幅度增加能源消耗量(见图2)。

图2.图表ES-1摘自美国环境保护署(EPA)报告(2007,8月2日)

截止2014年,摩尔定律尚未失效。但当它失效时,最终将是因为芯片和晶体管设计中涉及的物理性限制导致,与数据中心环境无关。

在美国环境保护署(EPA)公布其数据中心报告的同时,工业界领袖们也注意到能效问题,信息技术设备(ITE)厂商们开始在他们的设计中除了性能之外更加注重能效;同时数据中心的设计和运营人员开始在可靠性和成本之外进行能效设计;运营商开始意识到提高能效并不需要牺牲可靠性。

传统冷却与架空地板的消失

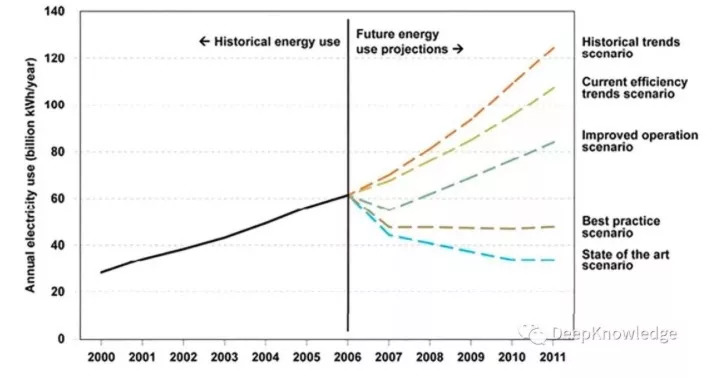

几十年来,计算机机房和数据中心采用架空的活动地板系统向服务器提供冷气流。从机房空调(CRAC)或机房空气处理机组(CRAH)出来的冷气流加压架空活动地板的下面空间形成静压箱。风口地板则作为冷气流离开静压箱进入机房主空间的方式,风口地板理想的位置是在服务器进风口的前端。冷气流经由服务器后,产生的热气流通常会与冷空气混合后返回CRAC/CRAH并再次被冷却。更常见的是CRAC机组的设定值通过比对气流回风温度来控制冷却系统的运行。最常见的是CRAC机组室内风机恒速运行,并且CRAC机组内配置工业加湿器来提供增工业加湿度用的蒸汽。从冷却的观点来看,架空活动地板的主要好处是为需要的位置提供冷气流,而且几乎不费事的就可以简单地将一块架空活动地板换成风口地板(见图3)。

图3.传统架空地板冷却

多年来这个系统是计算机机房和数据中心更常见的设计。至今仍在这么应用。事实上,我还发现许多运营人员进入现代数据中心看不到架空地板和CRAC机组的惊讶。

传统机房气流系统依赖于舒适性冷却的一个原理:即通过输送相对少量的空调调节的气流,使这些冷气流与房间中较大量的空气混合以达到所需的温度。当信息技术设备(ITE)的功率密度较低时,这个系统完全可以正常采用。尽管这样的冷却系统有着效率低、冷却不均匀等等的缺点。但能满足低功率密度的环境需求。

就此,说架空活动地板已经过时有些夸张,因为很多公司仍在建造采用架空地板输送气流的数据中心。然而,越来越多的现代数据中心开始没有架空地板,改进的气流输送技术使得架空地板变得不再那么必要。

足够冷是多冷?

“拿一件夹克。”我们要去机房。”

信息技术设备(ITE)电气元件周边的热量必须移除,以免元件过热。如果服务器变得太热,控制板上的控制逻辑将会关闭服务器以避免对它造成损坏。

ASHRAE技术委员会9.9(TC9.9)为信息技术设备(ITE)确定合适的运行环境做了大量工作。我相信他们的那些出版物,特别是《数据处理设备的热指南》已经推动将数据中心从传统数据中心的“储肉柜”式转向更合适的温度。[原文作者备注:ASHRAE技术委员会TC9.9热指南推荐数据处理设备入口气流温度在18-27°C之间,相对湿度(RH)在20-80%之间来满足制造商已有的标准。UptimeInstitute则进一步建议将上限降低到25°C,从而可以允许运行中的一定的意外与变工况,或者补偿温度传感器、控制系统固有的误差。

明白TC 9.9的热指南是基于服务器入口温度而不是服务器内部温度,不是室温,当然也不是服务器出风温度非常重要。另外理解推荐和允许的运行环境概念也很重要。

如果服务器一直太热,但不至于热到它自己关闭,它的寿命可能会减少。一般来说,这种减少的寿命是服务器经历的高温和该高温环境持续时间的函数。通过提出一个更宽泛的允许范围,ASHRAE TC 9.9表明信息技术设备(ITE)每年可以有更多的时间运行在较高的温度下。

鉴于技术更新每3年会发生一次,信息技术设备(ITE)运行人员应该考虑它们的寿命减少与运行环境有着怎样的相关性。答案可能取决于特定情况下的细节。在更新率为4年或更少的齐次计算环境下,增加温度导致的失效率可能不足以去推动改进冷却设计,特别是如果制造商在比较高的机房温度下还会保修他们的信息技术设备(ITE)。而在期望设备具有较长寿命的混合计算环境下,温度可能需要保证投入更多的关注。

除了温度,湿度和污染物也会影响信息技术设备(ITE)。当信息技术设备(ITE)长期运行在不能接受的环境中,特别容易被湿度和污染物影响导致不良结果。当然,在极端情况下(比如有人把一桶水或泥土倒在电脑上),你们立马就能看到后果。

低湿度产生的问题涉及到静电(ESD)。类似大多数人经历过的,在干燥(湿度较低)的环境下,ESD很容易产生。然而,数据中心低湿度的ESD影响已另外分析清楚。在“数据中心的湿度控制是必须的吗?”(ASHRAE通讯,2010年3月),Mark Hydeman和David Swenson写道,只要信息技术设备(ITE)有外机箱,ESD就不是一个真正的隐患。另一种情况下,去掉ITE的外机箱,即使严格的进行湿度控制也不能保证不产生ESD。技术员去除外机箱后对内部元件进行操作时应该佩戴防静电腕带。

另一方面,高湿度确实对信息技术设备(ITE)构成了现实隐患。虽然冷凝水绝不应该出现,但在大多数数据中心它并不是一个重大隐患。主要的隐患来自湿的灰尘颗粒。基本上,较高的湿度使得空气中的灰尘更容易粘附在计算机中的电气元件上。一旦灰尘粘附,就会阻碍散热以及很可能对那些元件造成腐蚀。阻碍散热的后果非常类似于高温。

还有一些与污染物有关的隐患。比如灰尘会覆盖电子元件,阻碍散热。其中有一类灰尘,称为锌晶须,是导电的。在电镀锌架空地板上非常容易产生锌晶须。锌晶须可以被空气传播并带到计算机里。由于它们能够导电,可以在微小的内部元件中造成破坏性短路。UptimeInstitute在一篇题为“架空地板生成的锌晶须正引起导电故障和设备宕机”的文献中记载了这一现象。

除了物理颗粒污染物所带来的隐患外,还有与气体污染物有关的隐患。某些污染性气体对电子元器件有腐蚀性。

冷却过程

冷却过程可分解为如下步骤:

1.服务器冷却。从信息技术设备

(ITE)带走热量

2.房间冷却。从承载信息技术设备

(ITE)的房间带走热量

3.散热。热量转移至数据中心外部 的散热设备

4.冷却制冷。通过散热设备冷却后

的流体返回至白空间,从而保持空

间合适的环境条件。

服务器冷却

信息技术设备(ITE)的电子元件消耗电力转化为热量,这是牛顿物理定律:输入的电能与产生的热能能源守恒。当我们说服务器用电,我们的意思就是指服务器的电子元件正有效的把能源状态从电能态改变成热能态。

服务器内固体(电气部件)热量传递至流体(典型的是空气)通常通过另一个固体(服务器内的热沉),信息技术设备(ITE)的风扇吸入空气经由内部元件从而驱动传热。

一些系统使用液体从信息技术设备(ITE)吸收并带走热,通常这种液体的载热性能比空气更高效。我曾经见过三类这样的系统:

• 液体与热沉接触。液体流动通过服务器与内部的热沉接触,从而从信息技术设备(ITE)吸收热量并转移。

• 浸没冷却。信息技术设备(ITE)元件浸没在非导电液中。非导电液吸收热量并从元件转移。

• 相变非导电流体。非导电液喷雾冷却信息技术设备(ITE)的元件。液体相变成气态将热量带至另一个热交换器,热交换器内的气态被换热带走热量后相变变回液体。

在这篇文章中,我将重点放在风冷信息技术设备(ITE)的系统,因为这是迄今为止工业界更普遍采用的方法。

房间冷却

传统的数据中心设计中,气流从服务器吸收热然后与房间的其他空气混合,最终回到CRAC/CRAH机组。气流通过空调盘管时进行热交换将热量传递至CRAC/CRAH机组内的流体。对于CRAC,流体是制冷剂。对于CRAH,流体是冷冻水。制冷剂或冷冻水带走机房热量。CRAC/CRAH出来的冷空气通常温度为55-60°F(13-15.5°C)。CRAC / CRAH送出气流至架空地板下的静压箱,一般采用恒速风机。许多制造商和设计师的标准CRAC/CRAH配置是基于回风温度来控制机组的冷却运行。

设计布局与散热方式

虽然在没人关注能效的低热密度房间架空地板与自然冷却效果良好,然而无法满足热密度和能效增长的需求,至少达不到过去那样的效果。我曾在一个传统数据中心用温度表测量温度,在一个机架底部温度测得大约是60°F(15.5°C),同一机架顶部温度则接近80°F(26°C),另外还计算了一下PUE远远超过2。

人们开始去使用更佳实践以及包括热通道与冷通道,吊顶回风静压箱,架空地板管理和服务器盲板在内的技术来提高架空地板环境的冷却性能。这些方法肯定有益,运营者应该进行采用。

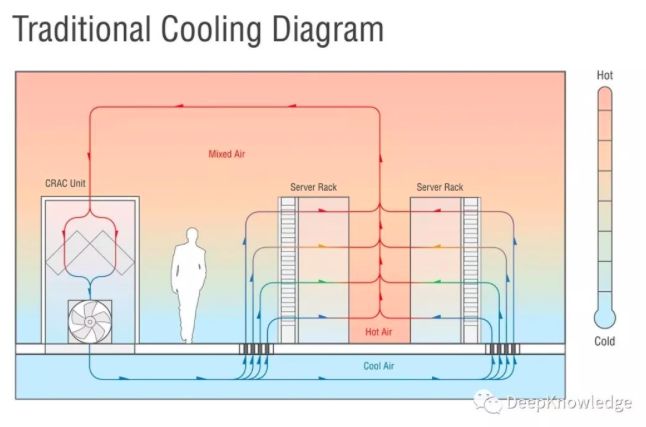

大约在2005年,设计专家和运行人员开始试验气流通道封闭法。这个想法很简单,使用物理屏障将服务器入口冷气流与服务器排出的热气流分隔。冷送风和热排风不再混合带来了很多优点,包括:

•更一致的入口气流温度

•可以提高供应白色空间的气流温度,增加了能效提高的选项。

•返回至空调盘管的气流温度更高,通常使得空调运行更有效率。

•房间可容纳更高热密度的设备。

理想情况下,在这样一个物理屏障封闭了的环境,气流以适合信息技术设备(ITE)运行的温度和湿度离开空气处理设备后只通过信息技术设备(ITE)设备一次,然后就返回空气处理设备再次冷却。

热通道封闭Vs冷通道封闭

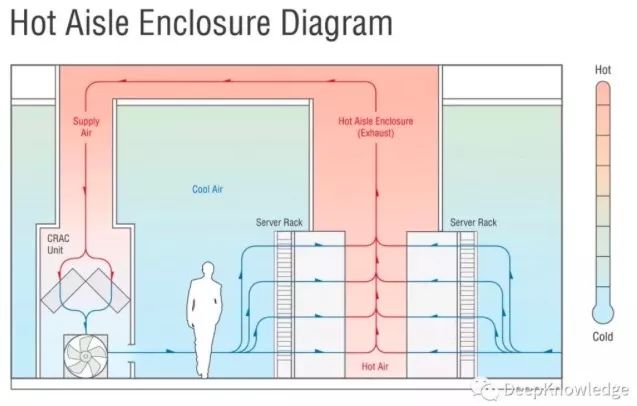

在冷通道封闭系统中,封闭来自空气处理机组的冷气流,同时服务器热排气允许自由返回至空气处理机组。在热通道封闭系统中,热排气被封闭并返回至空气处理机组,通常通过吊顶回风通道返回(见图4)。

图4.热通道封闭

未来预测(Crystal Ball)

虽然仍在建造和部署非常高功率密度的信息技术设备(ITE),但是大多数信息技术设备(ITE)的功率密度并没有跟上10年前建造项目时的预计增长。Sabey公司6年前设计的数据中心平均150瓦/平方英尺,并且公司还没理由去进行增加。当然,Sabey的数据中心可以在需要的地方有限度的容纳更高的功率密度。

在不久的将来,我期望带封闭通道的基于空气的冷却系统继续成为数据中心冷却的选项。从长远来看,见到越来越多采用液冷的冷却技术我也不会奇怪。

总结

Sabey公司开发和运营的数据中心拥有众多不同行业和各种规模的客户。作为一家服务提供商,Sabey公司通常不知道客户需要的技术或布局。Sabey公司的各个数据中心依托所处位置区域的气候条件采用不同的冷却技术。在气候温和的西雅图、半干旱气候的华盛顿中部和纽约市中心都有数据中心,他们坐落于单层新建建筑和改造的高层建筑内。

尽管有着这些变化和不确定性,但Sabey公司的数据中心设计与运行都有一些共性。都采用不设架空地板的热通道封闭技术,都有为服务器出口热气流服务的吊顶回风通道与为服务器入口气流服务的开放式房间。这些数据中心都采用某种形式的节能器。Sabey公司尽可能为风机、水泵与冷水机组采用变速电机,从而实现即使在轻负载条件下也能能效运行。

Sabey已经采用了带有热通道封闭的多种不同的冷却系统,并且我更喜欢在适合的地理区域采用IDEC空气处理机组(话说这款产品正是业界有口皆碑的蒙特为数据中心量身打造的典范之作哦)。我们发现这是一种耗水量比其名称含义更小的非常有效的系统。大部分时间这套系统运行在干式换热器模式。该系统相对实现了非常简单的控制程序,并且那种简单性还提高了系统的可靠性。在市政设施服务中断时该系统能够快速重启,一旦发电机启动提供了电力,风扇就会继续旋转并加速。储水槽里有着储存的水,于是蒸发冷却过程基本上没有重启时间。Sabey已经成功无故障的冷却着35-40 kW的机柜。

除非广泛采用液冷服务器,否则目前主要的节能途径仍然是优化风循环冷却气流,采用封闭通道。

本文翻译:郜卫华